麻豆 人妖 80G显存塞50个7B大模子!清华&OpenBMB开源增量压缩新算法

Delta-CoMe团队 投稿麻豆 人妖

量子位 | 公众号 QbitAI最新模子增量压缩本事,一个80G的A100 GPU粗略缓慢加载多达50个7B模子,简易显存约8倍,同期模子性能险些与压缩前的微调模子绝顶。

清华大学NLP实验室联袂OpenBMB开源社区、北京大学和上海财经大学的参议团队,建议Delta-CoMe。

这项本事的中枢在于愚弄骨干模子与任务专用模子之间参数增量(即Delta)的特色进行压缩,从而收尾有储支出和部署资本的大幅缩短。不仅有助于惩办资源瓶颈问题,更为多任务处理和模子部署开荒新的可能。

具体而言,Delta-CoMe将低秩领悟和低比特量化本事相结合,充分愚弄Delta参数的低秩本性,建议了一种全新的搀杂精度压缩次第。这种次第不仅粗略收尾接近无损的任务性能,还能权贵进步推理效力。

Delta-CoMe次第先容微调是增强预磨砺模子的紧迫技巧,不同任务经常需要不同的微调花式。举例Luo et al.[1]建议RLEIF通过Evove-instruction来增强模子数学推理才气;Wei et al.[2]愚弄Code snnipet合成高质地的教导数据来增多模子的代码才气。相干词,这些次第时常依赖高质地数据,并需要用心想象的计谋才能收尾权贵的成果。

在一些场景中经常需要具有不同才气的LLM同期处理问题,举例多田户场景,多任务场景以及端侧场景等等。一种当然的惩办有盘算推算是部署单个通用模子看成骨干,吞并多个具有出奇才气的Delta。

以Bitdelta[3]为例,它通过将模子的Delta压缩到1-bit,有用保留了模子在问答等场景中的才气。尽管该压缩次第在存储和推理效力上推崇出色,其在更复杂的任务(如数学推理和代码生成)上仍存在赫然的才气瓶颈。

针对这一挑战,THUNLP实验室聚拢北京大学和上海财经大学建议Delta-CoMe。这一次第结合低秩领悟和低比特量化本事,不仅权贵进步了模子在复杂任务上的推崇,还兼顾了压缩效力和践诺应用需求,为模子的高效部署提供了一种新想路。

与前东说念主的次第比较麻豆 人妖,Delta-CoMe次第的优点在于:

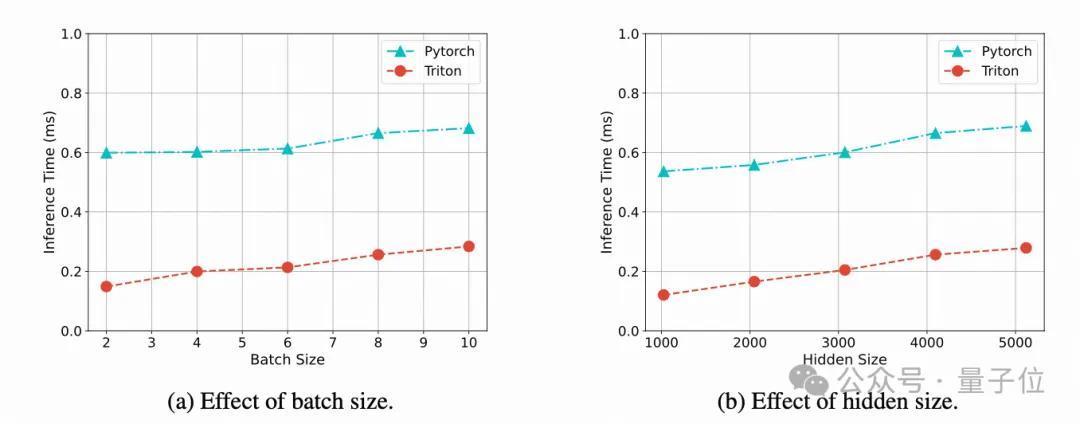

结合低秩与低比特量化,愚弄了Delta低秩的特色,并发现低秩领悟后的Delta是长尾分散的;之后选拔搀杂精度量化进一步压缩性能险些无损,比较于BitDelta等次第,在Math, Code, Multi-modal等复杂任务上,性能与压缩前的微调模子推崇基本接近推理速率进步,为搀杂精度量化收尾了Triton kernel算子,对比Pytorch的收尾花式,带来近3倍的推理速率进步跨越Delta-tuning,营救多精度Backbone,Delta-CoMe在成果上权贵优于LoRA微调,并不错用在多种精度的Backbone上

具体而言,Delta-CoMe率先选拔SVD进行低秩领悟,Delta 具有低秩性,进程低秩领悟之后,其特征值呈现出长尾分散的划定,仅有少数较大奇异值对应的奇异向量对最终的限度孝顺较大。

一个当然的意见,咱们不错凭据奇异值的大小进行搀杂精度量化,将较大的奇异值对应的奇异向量用较高精度示意,而较小的奇异值对应的奇异向量用较低精度示意。

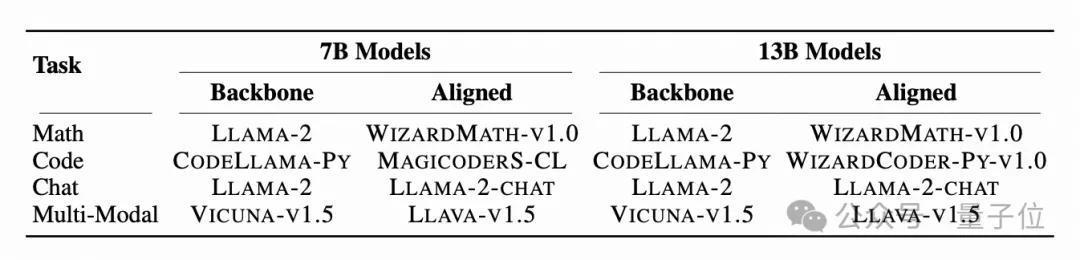

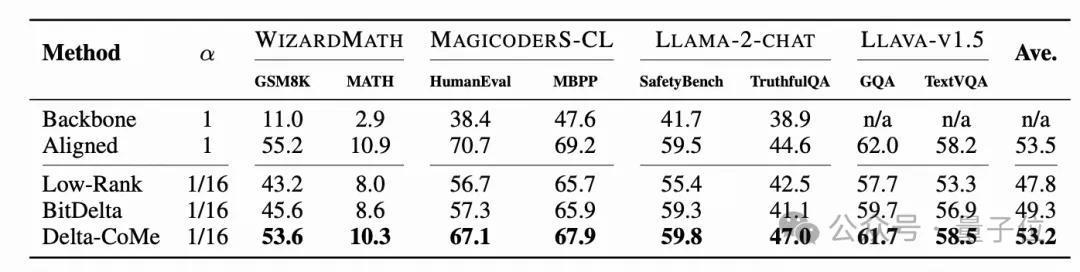

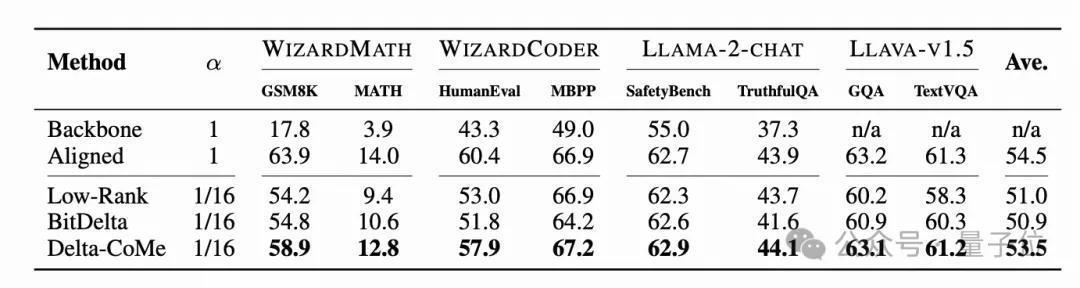

实验限度多个开源模子和 Benchmark 的实验考据了该次第的有用性。

使用Llama-2看成骨干模子,在数学、代码、对话、多模态等多个任务中进行实验,Delta-CoMe展现出平均险些无损的性能。底下划分是7B模子和13B模子的实验成果。

此外,还在Mistral、Llama-3等其它骨干模子上对不同的压缩次第进行了考据。

为了进步搀杂精度量化的议论效力,收尾一个Triton Kernel,比较于Pytorch的收尾花式,推理速率进步了约3倍。

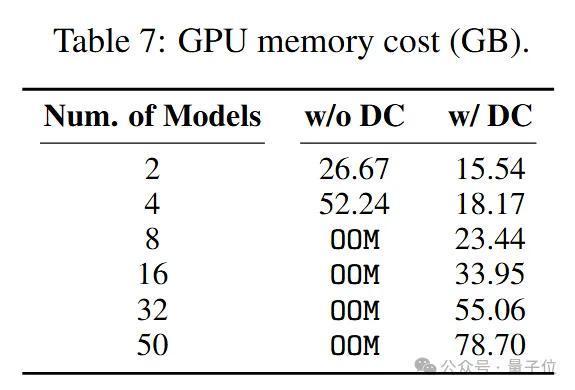

实验限度标明,使用一块80G的A100 GPU不错加载50个7B模子。

临了,还比较了Delta-Tuning和Delta-Compression的成果相反(Delta-Tuning指的是通过磨砺部分参数进行微调,Delta-Compression指的是先进行全参数微调,再将微调带来的模子参数增量进行压缩)。其中Delta-Tuning选拔的是LoRA。Delta-CoMe对比LoRA在调换的存储支出下,性能权贵进步。

Delta-CoMe 通过结合低秩领悟和低比特量化,不仅收尾了大幅度的存储压缩,还在复杂任务如数学推理、代码生成和多模态任务上保管了与压缩前模子绝顶的性能推崇。比较于传统的微调次第,Delta-CoMe 展现出了更高的机动性,尤其在多田户和多任务场景中具有权贵的应用价值。此外,借助 Triton kernel 的优化,推理速率获取了权贵进步,使得部署大边界模子成为可能。翌日,这一次第的后劲不仅在于进一步优化模子存储和推理速率,也有望在更无为的践诺应用中鼓励大谈话模子的普及和高效运作。

参考文件[1]Yu, L., Jiang, W., Shi, H., Jincheng, Y., Liu, Z., Zhang, Y., Kwok, J., Li, Z., Weller, A., and Liu, W.Metamath: Bootstrap your own mathematical questions for large language models. In The Twelfth International Conference on Learning Representations, 2023.

[2] Luo, Z., Xu, C., Zhao, P., Sun, Q., Geng, X., Hu, W., Tao, C., Ma, J., Lin, Q., and Jiang, D. Wizardcoder: Empowering code large language models with evol-instruct. arXiv preprint arXiv:2306.08568, 2023b[3] Liu, J., Xiao, G., Li, K., Lee, J. D., Han, S., Dao, T., and Cai, T. Bitdelta: Your fine-tune may only be worth one bit. arXiv preprint arXiv:2402.10193, 2024b.Paper伙同:https://arxiv.org/abs/2406.08903Github伙同:https://github.com/thunlp/Delta-CoMe

— 完 —

量子位 QbitAI · 头条号签约

热心咱们麻豆 人妖,第一时刻获知前沿科技动态